4月17日凌晨,OpenAI正式宣布推出目前OpenAI系列里能力最強的推理模型——o3模型和o4-mini模型。

去年12月,OpenAI就預熱過o3推理模型,當時強調的重點是o3模型在解決困難問題上的能力,要顯著強于OpenAI第一代推理模型o1。

而此次正式發布中,OpenAI不僅強調了o3模型在能力上的領先性,同時還強調了o3的Agent能力,且強調o3是第一代能夠在思維鏈中使用圖像進行推理的模型。

自主調用工具是Agent能力最重要的體現。OpenAI表示,曾看到o3為了解一個特別難的任務,連續調用了大約600次工具。

隨著OpenAI的O系列、DeepSeek R1等推理模型日趨成熟,業內普遍認為,只需一條指令即可完成整套任務的AI Agent能力將迎來顯著提升。

相比于Google,Anthropic等從去年就開始宣傳Agent能力,甚至已經開始推動MCP、A2A等Agent協議普及的公司,OpenAI之前在Agent能力上的布局相對缺失。而今天的發布,證明OpenAI在Agent能力上,仍然有自己的思考和布局。

OpenAI宣布, 從今天開始,Plus、Pro和Team用戶就可以使用o3模型和o4-mini模型了,接下來幾周還會推出o3-pro模型,替代過去的o1-pro模型。

在彩蛋環節,OpenAI還表示,未來將發布一系列編程工具,重新定義AI時代的編程,首發的是一個叫Codex CLI的開源輕量化編程agent。Codex CLI可以直接使用OpenAI的模型(最終包括o3和o4-mini),接管本地計算機終端命令行界面,直接進行代碼編寫和文件移動等等。

OpenAI的展示很有意念編程(vibe coding)的味道了:直接在網頁上截圖了一個別人編程好的效果圖,丟給Codex CLI,跟它說做一個html文件復現這個效果,并做一些改動。很快,Codex CLI就自己寫了代碼,調用了系統工具,復現出了一個類似的效果。

OpenAI今日的發布大致符合預期——o3和 o4-mini已經預熱多時,視覺推理與Agent能力也早已在其他公司的模型中有所體現。

不過,從今天的發布中仍能看出OpenAI在Agent等前沿方向上的布局節奏,以及將已有能力產品化的獨特能力。

OpenAI的模型迭代,也再一次重新肯定了后訓練Scaling Law的存在。目前看來,AI模型在接下來幾年,仍然會出現能力的快速進化,還未到達瓶頸。

OpenAI的Agent能力,目前更多的是調用自身的工具

OpenAI此次發布的一大亮點在于Agent的能力。最初的兩個展示都與工具調用能力有關。

第一個展示是研究員給了OpenAI一個十年前寫過的論文圖片,讓o3模型找到一個特定的結果,并和最新的研究成果進行比較。

o3模型首先利用內置的視覺推理能力,放大圖片,找到了研究員想要的特定結果,然后根據圖片中的內容進行推理,算出了論文推導的數值,然后使用搜索功能,查找了十篇論文,比較了最新研究成果與作者十年前論文的結果的區別,最后給出了自己的建議。

第二個演示是研究員問OpenAI,根據我的興趣,讀新聞,告訴我一些我可能感興趣的事情。

這個演示則利用的是OpenAI內置的記憶工具——OpenAI幾天前剛剛宣布OpenAI的模型目前有了可以訪問用戶全量記憶的能力。

o3模型先是訪問記憶后,找出用戶喜歡水肺潛水和彈奏音樂,然后利用搜索功能,找到了一條交叉兩條興趣的新聞:研究人員會錄下健康珊瑚礁的聲音,然后用水下揚聲器在海里播放這些聲音,以保護珊瑚。

最后o3模型使用了OpenAI的canvas工具和數據分析工具,生成了一個漂亮的博客界面,完成了任務。

可以看到,在OpenAI目前的布局當中,Agent能力更多的是調用OpenAI的內部工具。

不過,在基礎的工具調用能力水平存在的情況下,如果想要接入其他工具,似乎也并不是很難。OpenAI今年3月剛剛宣布接入MCP協議,為之后使用其他工具打下了基礎。

o4-mini 表現出色,RL的Scaling Law仍在起作用

雖然在去年12月OpenAI曾經預熱過o3模型的具體能力,這次正式發布,官方表示因為進行了「對推理成本和實用性做了大量優化」,在評測結果上,OpenAI表示可能會有差別。

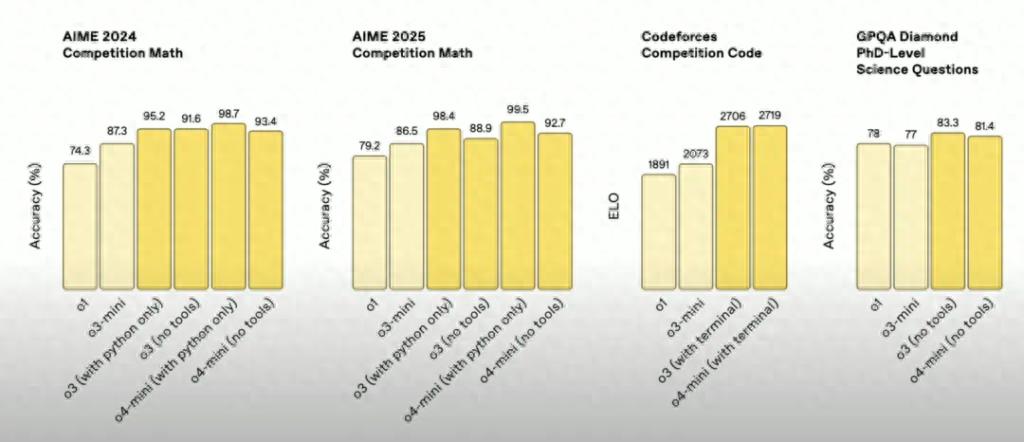

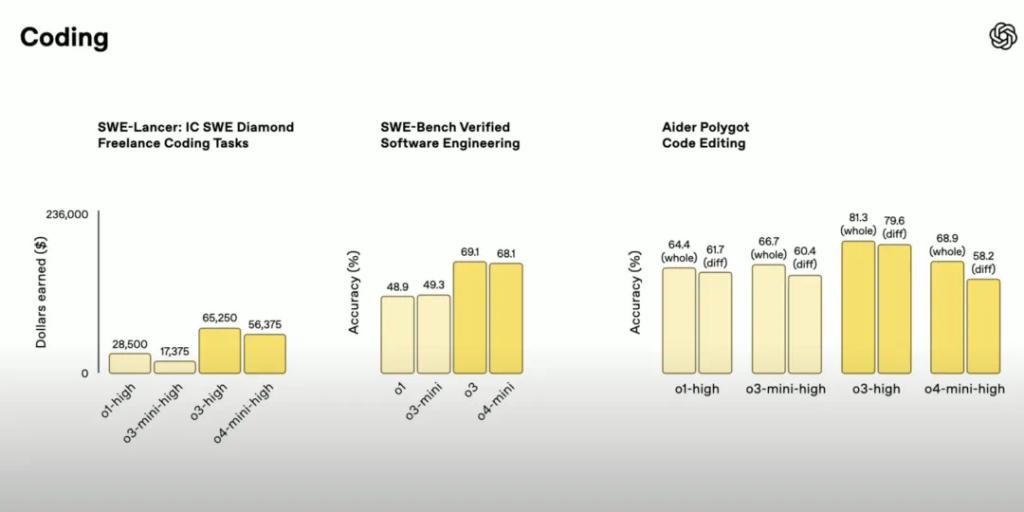

在發布會直播中,OpenAI展示了幾組測試結果,o3模型和o4-mini模型在數學能力、代碼能力和多模態能力上都表現出色: